日本マイクロソフトは、ソーシャルAIチャットボット「りんな」に「共感視覚モデル」を搭載したスマートフォン向けAI「りんな」を発表した。

スマートフォン向けAI「りんな」は、現在提供中のソーシャルAIチャットボットAI「りんな」に、最新の画像認識エンジン「共感視覚モデル(Empathy Vision model)」を採用したもの。共感視覚とは、AIが見た風景やものなどについて、その名称や形、色などの「認識結果」を回答するのではなく、その風景やものを見た「感想」を述べることを指す。従来の画像認識技術に「感情と共感」を与えることで、見たものについて「認識結果」だけを伝えるのではなく、リアルタイムで感情のこもったコメントを生成し、ユーザーと音声による自然な会話が可能になる。

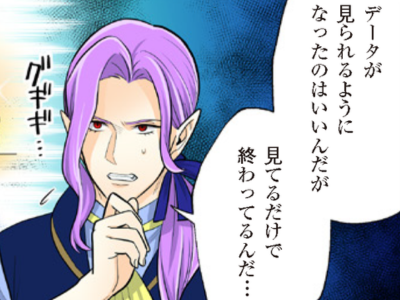

たとえば、従来のAIとスマートフォン向けAI「りんな」が、以下の画像にそれぞれコメントした場合、次のような違いがある。

従来のAIの場合:「人です。子供です。犬です。車です」

共感視覚モデル(りんな)の場合:「わぁすてきな家族。お休みかなー。あ、車が動きそう!気を付けて」

スマートフォン向けAI「りんな」には、マイクロソフトの研究開発部門マイクロソフトリサーチによる最新の画像処理、自然言語処理、音声認識および音声合成技術が採用されている。なお、スマートフォン向けAI「りんな」は現在開発中で、一般公開時期は未定だ。

【関連記事】

・日本マイクロソフト、AIチャットボット「りんな」を活用したマーケティングソリューションの提供を開始

・ユーザーの歌声を学習して女子高生AIりんなも歌うまに?nana、音声データを日本マイクロソフトに提供

・ポケモン公式LINEアカウント、AI導入 日本マイクロソフトの技術活用

・ウィゴーが「女子高生AI りんな」をアルバイト採用~EC上で“りんなのファッションチェック”提供

・人工知能と人間は感情を共有できるか、「女子高生AIりんな」にTVの放送実績データを取り込み研究へ