XML版サイトマップとは?

SEOのためのサイトマップは2つある。一般ユーザーにナビゲーションなどの利便性をもたらすWeb版サイトマップと、ロボット巡回を促進する検索エンジン専用のXML版サイトマップである。Web版サイトマップもロボット巡回を促進する効果はあるし、各検索エンジン側もサイトに設置することを奨励している。XML版サイトマップはこれをさらに推し進めるもので、sitemaps.orgにて標準化された書式が公開され、かつGoogle・Yahoo!・Microsoft(Liveサーチ)などの各社もサポートを宣言している。後編では、XML版サイトマップをSEOとして強化するためにGoogleやYahoo!のツールの活用法を解説していくことにする。

ロボットとは?

さてそもそも、Web版であれXML版であれサイトマップは、SEOの強化という点ではロボットの巡回を促進するものにほかならない。SEOの初心者は、「えっ、それだけ?」と落胆するかもしれない。あるいは過大に期待して「PageRankが上がるでしょう?」「各ページへのリンクが増えるから上位表示にも有利なのでは?」と願望をふくらませる人もいるだろう。しかし、サイトマップのSEO的価値は、まずは「ロボット巡回の促進」であり、それ以上でも以下でもないとご理解いただきたい。

そして中級者ともなれば、ロボット巡回の重要性が身に染みている。サーバの生ログを見たり、検索結果画面の自サイト・自ページのキャッシュの日付けを気にしたりするはずだ。新しいページをアップしたり、ページを修正したり、リンクを増やしたり、これらのことはロボットが巡回してこない限り反映されない。つまり、「SEOの沙汰もロボット次第」なのである。

SEOとしてのロボット巡回

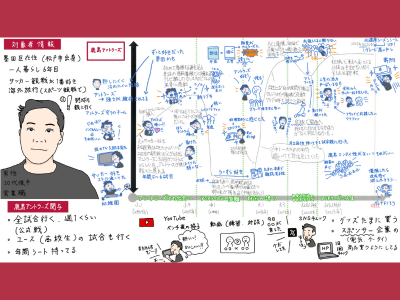

筆者ライオン丸が運営しているSEO塾では、検索エンジン対策を4つの条件に区分していることは、前編でもお伝えしたがここで少し詳しい内容で復習しよう。

- ロボットの巡回

検索エンジンが、われわれのウェブページを見つけ、ページのソース(中身)をお持ち帰りする。 - インデックスの追加

(1)で持ち帰ったページのソースを、検索エンジンが独自に加工や編集を行い、「索引付け」してデータベースに保存する。索引付けをするので、「インデックス」と呼ばれる。 - アルゴリズムの適合

ユーザーのキーワード検索に対して、順番を決め並べ替えをして表示しているが、その順番とか並べ替えのルールのことを「アルゴリズム」と呼ぶ。アルゴリズムの適合度が高いほど上位に表示される。つまり、1ページ目とか2ページ目とかに表示させたいのならば、もの凄いアルゴリズム適合度でなければならない。 - ペナルティの回避

さらに、(3)のアルゴリズム適合度が非常に高くても、検索エンジンの側が、おかしい、不適切、インチキなどを感じ取って、順位を落としたり排除したりすることがある。Googleのスパムフィルタなど。

さて、(1)ロボット巡回の段階で、「見つけてもらえない」「ソースを持って帰ってくれない」ということであれば、永遠に検索にかかることがない。この世には存在しないWebページという罰を受けるに等しいのである。よって、ロボット巡回こそ、SEOの基礎の基礎、検索エンジン対策の初歩の初歩、何が何でもクリアするべき第一条件なのである。

中抜きとしてのXML版サイトマップ

ロボットは通常、リンクをたどってやって来る。しかもすでにインデックスされているページのリンク、つまり検索エンジンに登録済みのページからリンクを受けていなければならないし、インデックス済みページからリンクを受けているからといって巡回が保証されるわけでもない。

ロボットが来なければ何もはじまらないのに、サイトオーナーの思い通りにはならないところにじれったさがある。そして、XML版サイトマップこそは、他ページからのリンクというまどろっこしい手続きを飛ばして、つまり中抜きでダイレクトにロボットにページの存在を知らせることができる救いの神と期待ができそうなのである。

よって、XML版サイトマップを用意したなら、われわれがやるべきことは、このサイトマップを検索エンジンに伝えることのみである。そうすれば遅かれ早かれ、ロボットはXML版サイトマップに記載されたわがサイトの各ページを巡回しはじめるだろう。

前編では、このXML版サイトマップのアドレスをrobots.txtに記述することで、最低限の検索エンジンへの申告となることを書いている。後編では、さらにGoogleやYahoo!のツールを活用して、XML版サイトマップによるSEOの強化について解説していこう。

Yahoo! Site Explorer

この「ヤフー・サイト・エクスプローラ」は、残念ながら日本のYahoo!では提供されていない。